Aby zdać sobie sprawę z tego, czym jest plik “robots.txt”, należy zwrócić uwagę na ogrom pracy, które roboty wyszukiwarek internetowych, muszą wykonywać każdej godziny. Ogromne ilości stron internetowych jest skanowana pod kątem wyszukiwania odpowiednich treści dla użytkowników. Plik robots.txt, można powiedzieć, że odpowiada za usprawnienie całego procesu.

Spis treści:

- Czego dowiesz się z tego artykułu?

- Robots.txt – czym jest?

- Jak wygląda robots.txt?

- Znaczenie poszczególnych elementów pliku robots.txt

- Dlaczego robots.txt jest ważny?

- Jak sprawdzić czy posiadam plik robots.txt?

- Jak stworzyć plik robots.txt?

- Jak przetestować plik robots.txt?

- Jak poprawić skanowanie strony przez Google?

- Przykłady plików robots.txt

- Podsumowanie

Czego dowiesz się z tego artykułu?

Z tego artykułu dowiesz się czym jest tajemniczo brzmiący plik “robots.txt”, z czego się składa, a także jak duże znaczenie ma mały plik tekstowy, wobec ogromnych rozmiarów zasobów internetowych. Co więcej, przedstawiliśmy sposób jak sprawdzić, czy Twoja strona posiada plik robots.txt, a także 3 sposoby na to, jak go stworzyć.

W ostatniej części artykułu znajdziesz informacje dotyczące przetestowania poprawności robots.txt oraz przedstawiliśmy przykładowe komendy, które możesz wykorzystać we własnym pliku. Wszystko po to, aby poprawić skanowanie Twojej strony przez Google. Zapraszamy do lektury.

Robots.txt – czym jest?

To mały plik tekstowy, który jest swoistą instrukcją Twojej strony dla robotów wyszukiwarek. Wyznacza on pewnego rodzaju granicę, tego co może być skanowane. Jeśli np. nie chcesz, aby Google brało pod uwagę zakładkę, w której masz zamieszczony cennik, wystarczy, że w pliku robots.txt zablokujesz dostęp do tej części strony.

Jak wygląda robots.txt?

Na wstępie warto zaznaczyć, że nie musi on się znajdować na naszej stronie, w przypadku gdy chcemy, aby cała witryna była skanowana przez wyszukiwarki. Jednak jeśli poddajemy naszą stronę czynnością optymalizacyjnym pod kątem SEO, najprawdopodobniej taki plik już mamy lub będziemy mieć. Jak wygląda najprostszy kod, którego możemy użyć w pliku?:

User-agent: *

Disallow: /cennik/Znaczenie poszczególnych elementów pliku robots.txt

Wyżej przedstawiony kod, może nam mówić raczej niewiele. Dlatego warto poznać poszczególne jego elementy i dowiedzieć się za co one odpowiadają.

User-agent

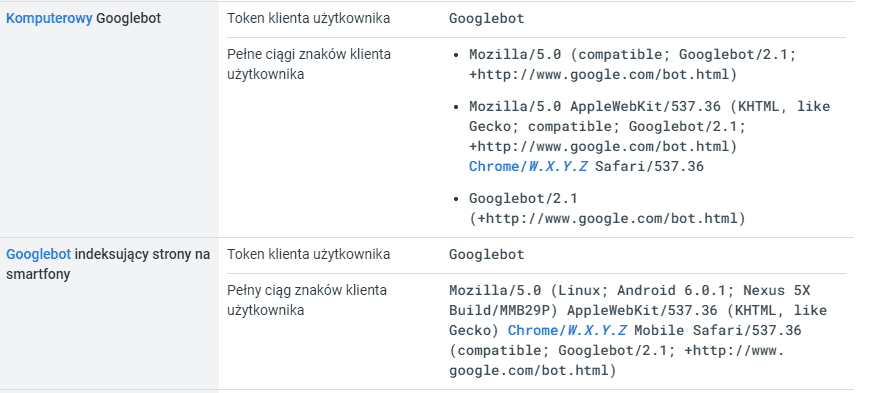

W pliku robots.txt wyznaczając obszary strony, które mają być skanowane przez roboty wyszukiwarek, możemy wyznaczyć dla różnych robotów, inne wytyczne. Oznacza to, że możemy wskazać np. który robot Google, do jakich części naszej strony będzie miał dostęp podczas jej skanowania. W przypadku, gdy nasz kod wygląda tak “User-agent: *”, komenda będzie dotyczyła wszystkich możliwych robotów wyszukiwarek. Nie ma konieczności wymieniania ich wszystkich z nazwy.

Może zdarzyć się tak, że będziemy potrzebowali wyłączyć dany element naszej strony ze skanowania tylko konkretnego robota. W tym celu warto przywołać kilka najpopularniejszych oznaczeń crawlerów, które skanują kod naszej strony, na potrzeby np. konkretnych narzędzi:

- Główny bot Google – Googlebot

- Google Ads – AdsBot-Google

- Google Zdjęcia – Googlebot-Image

- Google Wideo – Googlebot-Video

- Google News – Googlebot-News

Allow oraz Disallow

Komendy “Allow” oraz “Disallow” dosłownie można tłumaczyć z języka angielskiego jako “pozwolić na” oraz “uniemożliwić”. Jeśli po tej komendzie w pliku robots.txt będzie znajdował się tylko slash (“/”) to będzie to oznaczało, że żadna część naszej witryny nie jest zablokowana dla robotów wyszukiwarek – są to ustawienia domyślne robotów. Jeśli chcemy, aby konkretny robot nie miał dostępu do danej części kodu strony, musimy wykorzystać formułę “Disallow”.

Komenda “Allow” przydaje się w momencie, gdy w wybranym przez nas obszarze kodu, chcemy dodać jakiś wyjątek. Możemy wtedy zablokować dostęp np. do konkretnego folderu, oprócz jednego z plików, który się w nim znajduje.

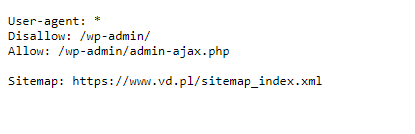

Wskazanie mapy strony w formacie xml

Za pomocą pliku robots.txt możemy także wskazać adres URL mapy naszej strony, która jest niezwykle istotna i jej posiadanie, brane jest pod uwagę przy ustalaniu pozycji w wynikach wyszukiwania w Google. Jak to zrobić? Pod wszystkim interesującymi nas komendami, musimy dodać komendę “Sitemap” i wpisać adres URL mapy naszej strony:

Sitemap: https://przykład.pl/sitempa.xmlDlaczego robots.txt jest ważny?

Pomimo, że nie zmienia on funkcjonowania Twojej strony i nie musisz go posiadać, to jest on przydatny w przypadku prowadzenia skomplikowanej strony, która zawiera interaktywną, dynamiczną treść. Wyobraź sobie, że na swojej stronie internetowej chcesz założyć coś, a`la YouTube i każde nagranie będzie posiadało własną podstronę. Przeskanowanie tak ogromnego zasobu może się strasznie rozciągać w czasie. Natomiast Google, nie zawsze musi wszędzie zaglądać.

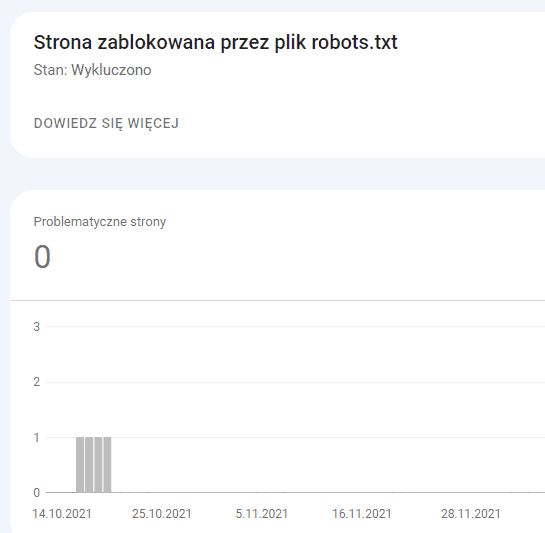

Stworzone przez Ciebie ograniczenia, mogą również być przydatne z punktu widzenia optymalizacji crawl budgetu. Google dostanie jasny sygnał do skanowania najistotniejszych rzeczy pod kątem SEO, pomijając treści, które mogłyby np. negatywnie wpłynąć na Twoje pozycję w wynikach wyszukiwania.

Jak sprawdzić czy posiadam plik robots.txt?

W tym celu najprościej jest wykorzystać swoją przeglądarkę. Jeśli posiadamy plik robots.txt to po wpisaniu jego nazwy po naszej domenie, powinien wyświetlić się nam na ekranie. Jeśli nie zostaniesz przekierowany do strony z zawartością “robots.txt”, która została przedstawiona powyżej, oznacza to, że nie posiadasz tego pliku.

przykład ścieżki: https://www.vd.pl/robots.txt

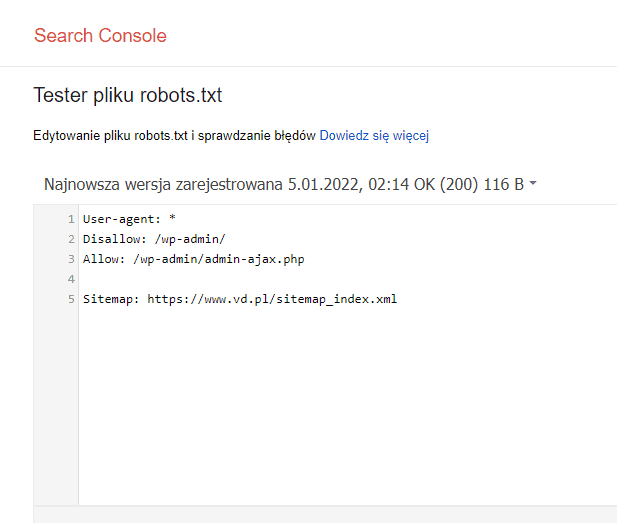

Można również przejść na stronę starej wersji Google Webmasters do zakładki Tester pliku robots.txt i tam sprawdzić czy formuła jest poprawna.

Jak stworzyć plik robots.txt?

Istnieje kilka rodzajów pliku robots.txt, które są przydatne w zależności od sytuacji, w której się znajdujesz. Wyróżnia się:

- Statyczny

Możesz utworzyć go w sposób ręczny i bardzo prosty. Tworzysz zwykły plik tekstowy z rozszerzeniem “.txt” i po prostu umieszczasz go na hostingu. Następnie według własnych potrzeb definiujesz komendy dla robotów wyszukiwarek.

- Generator plików

Dzięki tym narzędziom, nie musisz znać zasad pisania tekstu robots.txt. Generator poprosi Cię o podanie podstawowych informacji, które są istotne dla pliku, np. jakie roboty chcesz zablokować. Cała reszta zostanie wykonana automatycznie.

- Dynamiczny

Istnieje także sposób generowania pliku robots.txt z poziomu CMS`a. Generuje się go za pomocą systemu, którego ten plik dotyczy. Co to oznacza? Robots.txt w takim wariancie jest tworzony i aktualizowany zależnie od wybranych przez nas ustawień indeksowania dla danej sekcji na naszej stronie. Robi się to w sposób automatyczny, dzięki czemu nie trzeba pamiętać o edytowaniu pliku.

Jak przetestować plik robots.txt?

Aby przetestować plik robots.txt, posłużyć się możemy Google Search Console. W panelu musimy wybrać swoją stronę, a potem z zakładki “Pobieranie”, wybieramy opcję Tester pliku robots.txt. Dzięki temu możemy tworzyć i na bieżąco sprawdzać, czy tekst naszego pliku będzie poprawnie skonfigurowany. Google Search Console będzie przekazywało komunikaty na bieżąco.

Jak poprawić skanowanie strony przez Google?

Odpowiednio skonstruowany plik robots.txt może przyspieszyć skanowanie Twojej strony w Google. Prawdopodobnie kiedyś znalazłeś się w sytuacji, gdy wprowadziłeś wiele istotnych zmian na swojej stronie, rozbudowałeś content, a indeksowanie tego wszystkiego trwa całe wieki. Jeśli będziesz posiadał odpowiednio stworzony plik robots.txt, to cały proces przebiegnie znacznie szybciej.

Wskażesz elementy strony, nad którymi pracowałeś i mają zostać zaindeksowane. To sprawi, że roboty wyszukiwarek zdecydowanie szybciej zauważą te zmiany, a to pozwoli Ci na szybsze osiągnięcie spodziewanych efektów swojej pracy. Jeśli nie wiesz jak poprawić skanowanie Twojej strony przez Google, nie martw się! Skontaktuj się z nami! Zajmiemy się poprawnością Twojego pliku robots.txt i zajmiemy się osiąganiem przez Ciebie wysokich pozycji w wynikach wyszukiwania.

Przykłady plików robots.txt

Warto przywołać kilka najbardziej popularnych komend, które możemy wykorzystać w pliku robots.txt, w celu lepszego zobrazowania całości tematu artykułu:

- Zablokowanie dostępu do całej strony dla wszystkich robotów wyszukiwarek

User-agent: *

Disallow: /- Zablokowanie dostępu do konkretnych części strony dla wszystkich crawlerów

User-agent: *

Disallow: /kalendarz/

Disallow: /cennik/pozycjonowanie-stron/- Zablokowanie dostępu do całej strony dla konkretnego robota

User-agent: Googlebot

Disallow: /- Zablokowanie dostępu do jednego folderu z wyjątkiem konkretnego pliku

User-agent: *

Disallow: /folder/

Allow: /folder/plik.html- Zablokowanie konkretnego rozszerzenia plików

User-agent: *

Disallow: /*.jpg$Podsumowanie

Plik “robots.txt” jest swego rodzaju instrukcją obsługi naszej strony internetowej dla robotów wyszukiwarek. Należy pamiętać, że nie jest on niezbędny i jeśli go nie posiadamy, nasza strona będzie funkcjonować poprawnie. Jednak wszystko jest zależne od naszej konkretnej sytuacji. Z punktu widzenia SEO, plik robots.txt może być przydatny, aby roboty wyszukiwarek nie indeksowały obszarów naszej witryny, które mogą negatywnie wpłynąć na pozycjonowanie.

Dodaj komentarz